Ft

Ft

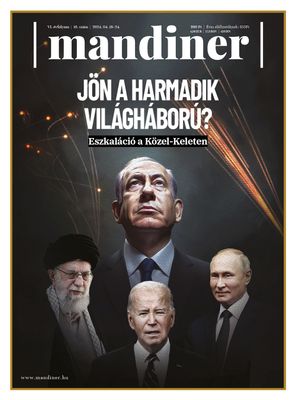

- Címlap

- Hírek

- Vélemények

- Rovatok

- Hetilap

- Szerzőink

- Előfizetés

Ft

Ft

04. 20.

szombat

Akták

AKTA

Háború Ukrajnában AKTA

Választás 2024 AKTA

Háború Izraelben AKTA

Lengyel választás Előfizetés

04. 20.

szombat

Regionális hírportálok

Bács-Kiskun - baon.hu Baranya - bama.hu Békés - beol.hu Borsod-Abaúj-Zemplén - boon.hu Csongrád - delmagyar.hu Dunaújváros - duol.hu Fejér - feol.hu Győr-Moson-Sopron - kisalfold.hu Hajdú-Bihar - haon.hu Heves - heol.hu Jász-Nagykun-Szolnok - szoljon.hu Komárom-Esztergom - kemma.hu Nógrád - nool.hu Somogy - sonline.hu Szabolcs-Szatmár-Bereg - szon.hu Tolna - teol.hu Vas - vaol.hu Veszprém - veol.hu Zala - zaol.hu Közélet

mandiner.hu magyarnemzet.hu szabadfold.hu hirtv.hu origo.hu Gazdaság

vg.hu figyelo.hu agrokep.hu Magazin

astronet.hu automotor.hu lakaskultura.hu likebalaton.hu mindmegette.hu travelo.hu dietaesfitnesz.hu vitorlazasmagazin.hu videkize.hu tvmusor.hu hirvilag.hu Bulvár

borsonline.hu ripost.hu metropol.hu life.hu she.hu Szolgáltatás

ingatlanbazar.hu freemail.hu koponyeg.hu videa.hu reblog.hu lapcentrum.hu Rádió

gongradio.hu hirfm.hu